pytorch安装GPU版本 (Cuda12.1)教程

使用本教程前,默认您已经安装并配置好了python3以上版本。

·

使用本教程前,默认您已经安装并配置好了python3以上版本

1. 去官网下载匹配的Cuda

Cuda下载地址

当前最高版本的Cuda是12.1

我安装的就是这个版本

小提示:自定义安装可以只选择安装Cuda Runtime。Nvidia全家桶不必全部安装。把全家桶全部安装完直接系统盘占了6G,很大的。

2. 安装pytorch

我之前使用的是pip install torch (2.0.0版本)

这样安装的torch是直接运行在CPU上的

想要使用GPU版本需要使用对应的cuda版本

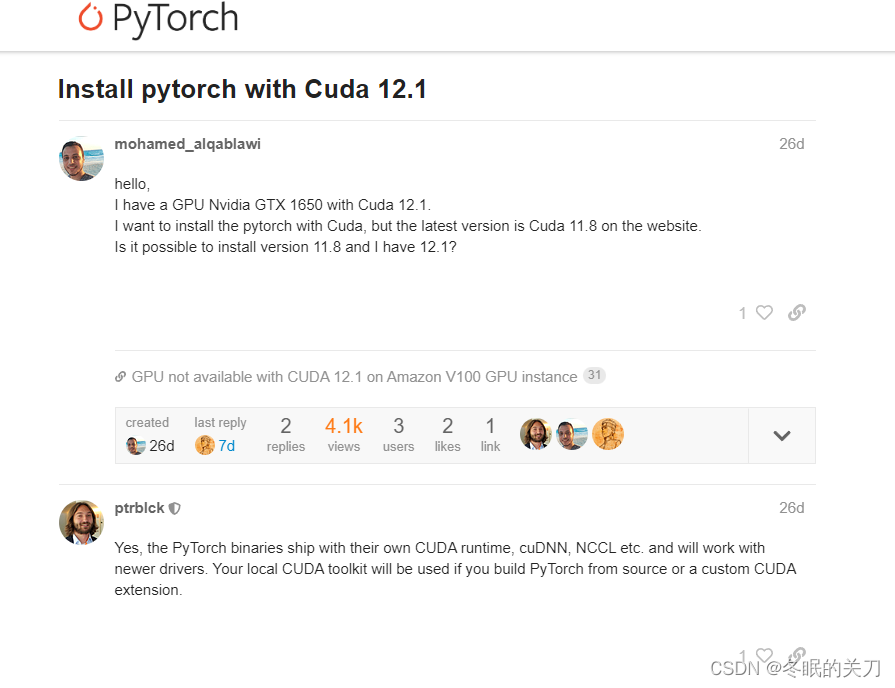

尽管pytorch官网上目前只给出了11.8的Cuda支持,但是社区明确表明了兼容高版本Cuda。

上图列出了我本地的torch相关库

可以看见这是一个混乱的构成(一团糟),

torch是cpu版本的

torchaudio是gpu版本的

torchvision是cpu版本的

可以用torch.cuda.is_available()的方法检验自己的torch是不是GPU版本

所以我决定直接全部卸载,重新安装GPU版本的torch全家桶

pip uninstall torch torchvision torchaudio

然后执行安装

这是本篇文章编写时最新版本的安装方法

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

3. 检验是否安装成功

使用pip list查看安装的版本是否正确

执行torch.cuda.is_available() 返回True说明已经在使用GPU版本了

4. (扩展)安装transformer

我之前的版本是4.27.2

但是我在启动huggingface的GLM项目时遇到了动态模块加载的报错。

已经有人给官方提了issue

建议使用4.26.1版本,比较稳定。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)